Des chercheurs tels que Willie Neiswanger de l’Université de Californie du Sud développent des cadres qui combinent la théorie des décisions et la théorie des utilités, dans le but d’améliorer la gestion de cette incertitude par l’IA.

Neiswanger met en évidence que les modèles de langage étendu ont des difficultés à bien exprimer des degrés de certitude, fournissant souvent des réponses qui semblent fiables même lorsque les informations sont insuffisantes.

Son objectif est de mieux quantifier l’incertitude, ce qui permettrait aux systèmes intelligents de rendre des décisions plus éclairées, en prenant en compte les préférences humaines.

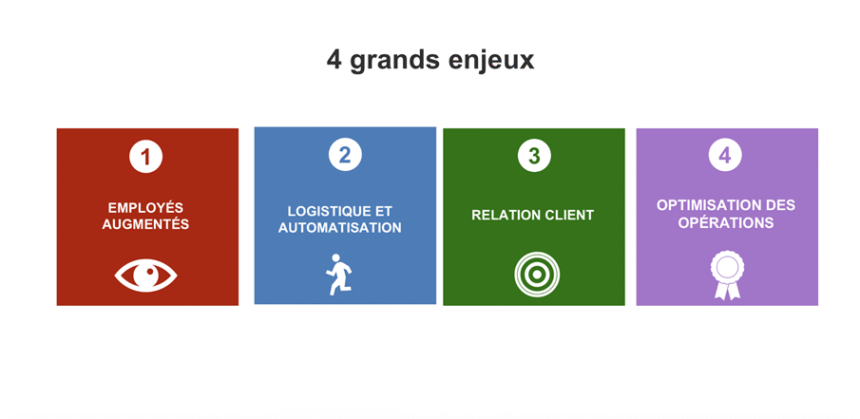

Les implications de cette recherche couvrent un large éventail d’applications, incluant la planification stratégique en entreprise ainsi que le soutien au diagnostic médical.

En intégrant les aspirations des utilisateurs au sein du processus décisionnel, il devient possible de formuler des recommandations qui, tout en étant techniquement judicieuses, tiennent également compte des valeurs humaines fondamentales.

Les prochaines étapes envisagées consistent à étendre ces méthodologies à d’autres secteurs, tels que la logistique et les soins de santé, tout en améliorant la transparence des processus décisionnels.

Cela permettra aux utilisateurs de mieux saisir les mécanismes et raisons qui sous-tendent les choix effectués par les modèles d’IA.L’article intitulé Que se passe-t-il quand l’IA confronte l’incertitude humaine ? est paru en premier sur IA Tech News | Restez à jour sur les évolutions de la technologie et de l’IA.

Source: IA Tech news